An diversen Stellen hab ich in den letzten Wochen/Monaten den Wunsch gelesen, sich über die Abwehr von übereifrigen (AI-)Bots auszutauschen, die die Server (u.a. Discovery) auch gerne mal lahmlegen. Unter anderem in der Findex-Mailinglist (Thema „Verbindungsabbrüche und stark verzögerte Antwortzeiten“) oder bei Mastodon von @acka47.

Nun schreib ich hier, allerdings ist es bei mir nur ein neben-neben-neben-Thema und nur wegen der aktuellen Personalsituation bei uns, d.h. ich bin da inhaltlich nicht gut aufgestellt. Im Wesentlichen haben wir Fail2ban für Webseite und Discovery im Einsatz, wo ich teils nach How to Avoid High CPU Load and Block Hackers and Bad Bots Effectively (2024-02-13) nachzubessern versucht habe und zusätzlich noch ein Perma-Jail eingerichtet habe, wo ich inzwischen riesige Netzwerkblöcke reinhaue, sobald die Seite abraucht.

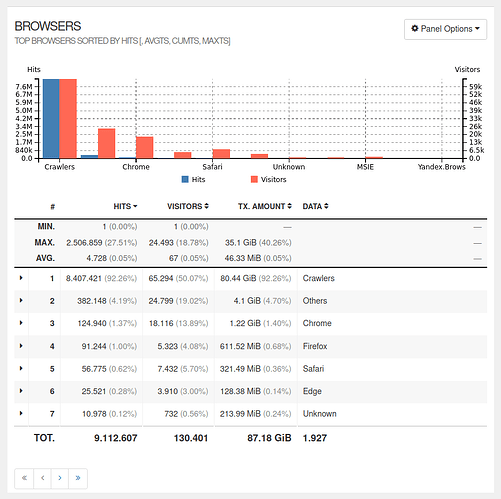

Das wesentliche Problem scheint mir, dass robots.txt-ignorierende Bots mit x IPs, ohne nutzbaren User agent kommen und damit einzeln von Fail2ban-Regeln schwer zu fassen sind in der Summe aber alles lahmlegen. Daher hab ich schon mal überlegt Crowdsec zu nutzen, aber auch wenn Linux-Server in 15 Minuten mit CrowdSec absichern stimmen würde (Edit 2024-12-11: Link scheint tot; gut auch Wie man Cyberangriffe mit CrowdSec abwehrt!), ist mir das im Moment zu heiß als neben-neben… Statt dessen nutz ich den Crowdsec IP-lookup und haue ggf. die Ranges in das Perma-Jail von Fail2ban. Und hoffe, dass bald eine Stelle nachbesetzt wird bei uns ![]()

Das ist natürlich sehr unschön.

Langer Rede, kurzer Sinn: gibt es hier Leute, die z.B. ihr Discovery gut in den abgesichert bekommen haben mit z.B. Fail2ban und robots.txt, die gute Tipps, ~Links/Literatur oder ggf. gar teilbare Scripts/Configs haben?

(Es gibt schon AI-Crawler in robots.txt blockieren?, aber mit einem etwas stärkeren Fokus auf robots.txt; falls zu redundant, gerne dieses Thema ignorieren).